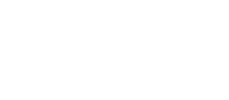

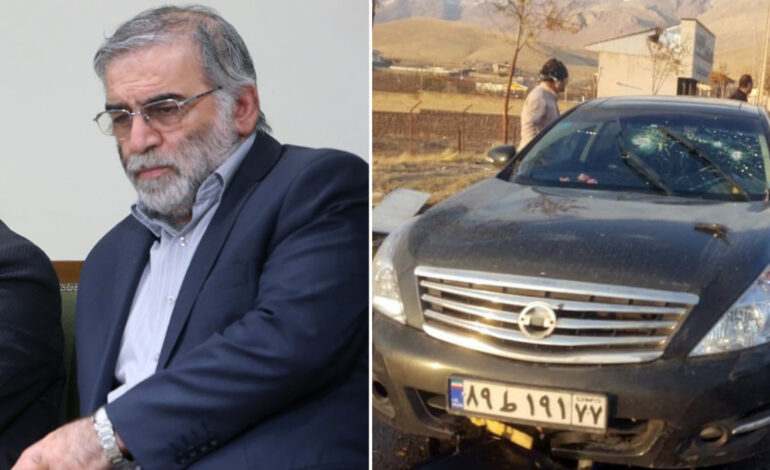

Foto: Irib Handout (EFE)

El asesino, un hábil francotirador, se colocó en su posición, calibró la mira del arma, la amartilló y tocó ligeramente el gatillo. Sin embargo, no estaba cerca, estaba mirando la pantalla de una computadora en un lugar no revelado a más de 1600 kilómetros de distancia.

Un informe del New York Times apunta a que el uso de inteligencia artificial y robótica estuvo detrás de la muerte de Mohsen Fakhrizadeh.

Convencido de que Fakhrizadeh lideraba la estrategia de Irán para construir una bomba nuclear, Israel llevaba al menos 14 años queriendo asesinarlo. Pero había habido tantas amenazas y complots que el científico ya no les prestaba mucha atención.

Según el informe del NYT, se utilizó una ametralladora asistida por Inteligencia Artificial (IA), donde ataque humano y tecnología se auxiliaron para tener una misión exitosa. La ametralladora operada a control remoto es un modelo especial de fabricación belga, capaz de disparar 600 balas en un minuto.

Aunque no se ha probado el uso de reconocimiento facial, sí fue un ataque preciso. Hasta ahora, ninguno de los gobiernos, ni Irán e Israel, han confirmado públicamente el uso de una pistola robótica, pero la investigación del medio estadounidense se basa en lo que ha recopilado con fuentes que eran familia de Fakhrizadeh. Y también representa una antesala para discutir los alcances de este tipo de tecnología y el futuro del espionaje por parte de grupos militares y de inteligencia.

El uso de IA por parte del Pentágono

Sumado a esta noticia, hace unos días el medio especializado en tecnología, The Wire, indicó que decenas de drones militares y robots parecidos a tanques volaron por los cielos y las carreteras a 40 millas al sur de Seattle, donde su misión era encontrar terroristas sospechosos de esconderse entre varios edificios.

La misión fue solo un ejercicio organizado por la Agencia de Proyectos de Investigación Avanzada de Defensa, una división de investigación del Pentágono; los robots estaban armados con nada más letal que transmisores de radio diseñados para simular interacciones con robots amigos y enemigos.

El simulacro fue uno de varios realizados el verano pasado para probar cómo la IA podría ayudar a expandir el uso de la automatización en sistemas militares, incluso en escenarios que son demasiado complejos y rápidos para que los humanos tomen todas las decisiones críticas.

Las demostraciones también reflejan un cambio sutil en el pensamiento del Pentágono sobre las armas autónomas, ya que se vuelve más claro que las máquinas pueden superar a los humanos al analizar situaciones complejas o al operar a alta velocidad, de acuerdo con el medio.

Ante este tipo de panorama ya han empezado a surgir iniciativas de control. Un informe presentado por la Comisión de Seguridad Nacional de Inteligencia Artificial (NSCAI), un grupo asesor creado por el Congreso de EU, recomendó, entre otras cosas, que el país dirigido por Joe Biden se revise una prohibición internacional del desarrollo de armas autónomas.

Y en el caso de las tecnológicas, hace unos años Google enfrentó protestas de empleados y protestas públicas después de suministrar tecnología de IA a la Fuerza Aérea a través de un proyecto conocido como Maven.

Con información de Expansión